相关推荐

苹果Vision Pro的“眼动交互”有哪些普通人创业机会?

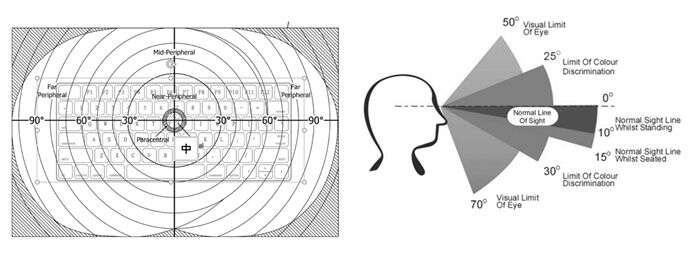

苹果 Vision Pro 的亮相,将眼动追踪技术融入进了核心交互中,Vision Pro 抛弃掉了传统的手柄,利用“眼动追踪+手势+语音”多模态的交互方式,用眼睛的转动来选择交互的对象,用手势来确定或者切换,眼动交互的重要度上升到了前所未有的高度。

苹果产品的很多特性往往会成为业界标准,慢慢出现在各类 AR 设备里,国内在 AR 上有所布局的大厂大概率会紧锣密鼓的在眼动追踪技术上加大研发力度。因此眼动硬件逐渐成为标配已经成为无可争议的事实。

图源:苹果 Vision Pro 眼动追踪

交互技术的重大改变,往往伴随着巨大的创业机会。例如以键盘和鼠标作为基础诞生 PC 电脑,进而诞生了大量基于鼠标键盘的图形化软件;例如以全面屏多点触控作为基础诞生了iPhone,基于触摸交互诞生了大量的 APP 应用。而且如今各个互联网大厂所分析的用户数据、精准营销、广告推送,都是需要用户付诸明确的交互行为才可以获得。

试想一下如果未来AR眼镜硬件性能进一步成熟,那么在未来基于眼动交互可能会有那些 APP 和创业机会呢?

一.眼动识图

图源:电影《大黄蜂》

在眼动追踪技术中,大家常听说注视点渲染,也就是实现眼睛看哪里图像渲染哪里进而降低了计算机的功耗和算力。但是大家可能不常听过的是-注视点图像识别,也就是实现眼睛看哪里图像识别哪里。

例如,苹果 Vision Pro 的前置摄像头实现的 AR 透视,再结合注视点图像识别可以间接的将眼睛注视点映射在现实世界,从某种意义上来说,这是让计算机在以用户的第一人称视角在感知并理解用户的所闻所见。那么如果计算机能够以用户的视角在感知世界,见你所见,思你所思,那么 AR 眼镜能够为用户提供的个性化服务的想象空间实在是很大了。

那么想象空间有哪些?其中就包括笔者早年曾探索 的AR 眼镜的识图购物。

图源:陈涛

上图是本人早年基于 Magic Leap One 研发的基于眼动识图购物的应用场景,图中白圈是用户的注视点,此时用户正在看着一架无人机,实现了对无人机图像信息的 AI 搜索,下单购买,虹膜身份识别,模拟了用户通过AR眼镜眼动的整个购物过程。

基于注视点图像识别实现眼动购物。通俗一点解释就是看什么买什么。例如,当一名男性用户在大街上看到一辆迎面驶来的新款汽车非常感兴趣,智能眼镜通过眼动追踪获取此时的眼动行为判断用户正在对目前注视的目标图像感兴趣,AR智能眼镜获取用户注视区域的汽车图像,将图像通过网络上传到云端计算机进行图像识别,识别出和感兴趣汽车一模一样的产品或者相似的商品。

当然商品不局限于汽车,还可以是数据库记录的任意产品。在一定程度上也可以理解成淘宝的拍立淘功能与眼动追踪结合在智能眼睛上呈现,这是潜在未来一种全新的购物体验。

或许在不久的将来,双十一不再是剁手,可能还需要挖眼了!!!!!!

总结来说,通过注视点图像识别技术能够最直接、最流畅的方式将用户、AR眼镜、物理世界三者联系在一起,基于这个思路还有大量的应用场景和工具型 APP 可以思考。例如可以把现在的图像识别的应用结合眼动注视点引导再实现一次,看哪里翻译哪里,看哪里哪里弹出评论、弹幕等等。

例如,用户在超市选购蔬菜,当用户看到某个蔬菜时。是否可以为其提供今晚的菜谱做法、热量提示、健康搭配。再比如今年爆火的 ChatGPT,AI 已经可以对图像中的场景进行理解,那么和 AR 眼镜的眼动追踪结合又能产生什么样的应用?可以想象眼动追踪是未来互联网的潜在理想 “流量入口之一”。

二.眼动数据应用

回顾前 20 年的互联网发展,互联网产品的商业模式可以大致分为广告收益、收中介费、以及近几年才流行的为产品本身价值付费。并且广告收益是早期 PC 互联网产品的主要营收来源,至今广告收益也占据了半壁江山。后来移动互联网兴起,通过手机可以追踪到个人用户,因此广告的推送讲究精准推送,通过 APP 收集用户的数据,进行用户画像分析,进而实现广告的精准推送。

以 Facebook 为例,旗下矩阵产品有 Facebook 主应用、Instagram、WhatsApp、 Messenger 以及其他多款工具和服务。

这些应用都可以收集多种类型的用户数据,以下是几个关键的类别:

• 用户基本信息:包括姓名、年龄、性别、职业、教育背景、地理位置等。

• 社交网络数据:用户的朋友列表、关注的人或页面、分享和评论的内容,以及用户在这些社交媒体平台上的其他互动。

• 用户行为数据:包括用户在应用中的浏览历史、点击行为、使用频率、停留时间等。

• 用户偏好和兴趣:根据用户的搜索历史、浏览内容、分享和点赞的帖子等来推断。

• 设备信息:包括设备型号、操作系统、浏览器类型、IP地址、移动网络信息等。

我将上述的用户数据都归为传统数据,因为这些数据获取的前提是需要用户经过主观思考并且付诸于交互行为输入到计算机中,例如上文提到的“用户行为数据”和“用户偏好和兴趣”。但是反观眼动数据,它不仅仅可以获取用户主观意识层面的行为数据,而且还可以获取潜意识层面的数据。

例如当我们看到一款心仪的新款汽车,人看的那一瞬间,人眼瞳孔直径的变化、眼跳的速度、眼跳距离、平滑追视的行为等都可能会有相应的变化,重点是这些行为人类不能自己自由控制,是客观生理的反应。也就是说眼动数据获取可以挖掘用户不经意之间的喜好、情绪等情感数据。

当然眼动数据的分析挖掘前提一定是建立在用户隐私保密技术和用户许可的情况下,正是因为眼动数据的潜在价值、侵入性都是前所未有的,所以苹果并没有开放眼动数据,或许可能是目前现有技术、监管、用户心智还有没有准备好利用眼动数据。

三.眼动数据隐私安全

在上文中提到眼动数据的存在巨大商业价值的同时,也存在更大隐私安全风险。比如单从注视点位置一种眼动数据,就可统计分析知道你对某一种事物的特定视觉偏好,例如某种设计风格的商品,是沉稳的、性感的、创意的、自由的、新中式的等等,往往人们对产品风格的偏好也与用户的性格和自我认知有相关性。

甚至对户外广告传媒行业也是一种全新变革,因为传统户外广告行业的广告效果是难以统计和量化的,他不像手机 APP 上的广告本身就是数据很好统计,但是在未来的更先进小巧的 AR 眼镜再结合眼动追踪,户外传媒将迎来变革。例如当AR眼镜用户看到某一块户外广告牌,不仅可以为用户呈现更多的内容,还可以户外广告投放商提供曝光度进行数据统计。

再比如在先进智能制造行业也可能会有积极的作用,在产品制造或者备货过程中,对于一件商品可能需要准备多种不同颜色、不同款式以适应不同客户细微差异,但是每种不同款式分别生产多少件?仓库分别存储多少货物一直是商家们的痛点,不然哪里来的双十二。但是结合 AR 眼镜的眼动追踪技术就可以以最低成本的方式统计分析大量用户商品视觉偏好,进而指导商家生产备货,类似商家付费请大量用户做产品视觉偏好的调查问卷,用户则可以通过授权眼动数据用于分析获得收益。

但是,苹果目前并没有把眼动数据开放出来,Vision Pro 眼动追踪所带来的隐私问题,这也是产品发布会上所强调的重点之一。

图源:苹果

Mike Rockwell 透露,Vision Pro 的解决方案是把眼动数据进行隔离并在后台进行单独处理,苹果称只有当用户进行双指捏合操作时才会释放结果,这样就很好规避了 APP 和网站获取隐私问题。

我的个人观点:虽然苹果目前没有开放眼动数据给开发者,但是我觉得在大趋势上一定会逐步开放给开发者,但是一定对使用眼动数据的开发者的要求和限制极高,当然也不排除苹果自己使用的可能。因为眼动数据的潜在商业价值太大了,即使有风险有困难,但一定会在利益驱使下得以解决,通过技术和制度的监管完善眼动数据的管控。

我想要引出的创业机会就是关于眼动数据隐私保护的相关技术,例如通过区块链技术让用户对自己的隐私数据有绝对的掌控权,而不只是属于某一家公司,用户可以将自己的眼动数据授权给某个 APP 分析使用,第三方企业对自己的眼动数据做了那些使用可以不可篡改的显示出来,企业使用了个人数据后还可以获得利润分成。

如果用户对自己的数据能够完全掌握,充分了解,能够做到这一点我相信用户对眼动数据的隐私排斥心理可以极大的缓解。所以眼动隐私数据保护、确权等方面是个有待解决的创业方向。在未来得眼动数据者可得未来互联网天下,得隐私保护者可得眼动数据。

四.眼动滑动输入法

图源:苹果

Vision Pro 输入文字的方式:一种是在空中漂浮的虚拟键盘,虚拟键盘可以让用户用手指在空中输入文字。

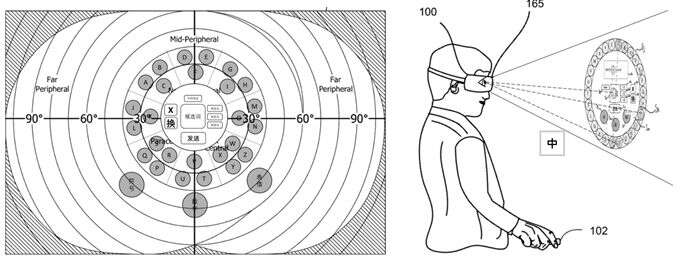

在互联网初期有大家熟悉的搜狗输入法,以输入法作为流量入口,通过搜索、广告、游戏等多种方式实现盈利。那么基于眼动交互是否存在某种输入法产品?

目前苹果 Vision pro 正在使用的手势识别和传统的 QWERTY 键盘布局作为文字的输入。但是实际上在未来手势识别的键盘输入方式不能够覆盖全部的生活场景。

比如想象一下在拥挤地铁车厢内,很难想象所有人都通过手势识别实现头显的交互和文本输入,因此在一些特定场景需要纯眼动交互来进行补充。当然如果要高效的办公还是需要物理键盘,如果是在不方便说话或公共的场景则适合使用眼动交互进行快速键盘文字输入,用眼睛键入字母需要解决技术问题有:

1.在输入过程中需要区分开眼睛的有意识的交互行为和无意识行为,有意识行为例如眼睛的交互行为,无意识例如视觉搜索行为。无意识注视行为会干扰对目标键的键入。

图源:陈涛

2. QWERTY 全键盘布局并不适用于眼动输入,因为 QWERTY全键盘上眼动滑行输入中,一次长距离的眼跳需要跨过太多键位,在眼跳过程中掠过太多无用的字符键位可能会造成误触键位,以至于输入错误的字符,这也会增加键入错误字符的几率,降低眼动滑动输入的体验。

图源:Eye Tracking Keyboard

3. QWERTY 全键盘布局是长方形的,长方形键盘可能会超出用户的视野范围,需要用户调整头部视角来进一步实现眼动输入,这是需要完善的体验。如 SideQuest 有一款眼动追踪打字 demo《Eye Tracking Keyboard》,可以发现通过眼动键入并不是很精准,另外需要一直转动头部来调整视野,本人认为更好的交互体验是尽可能少的让用户付出精力和运动。

眼动滑行输入法,图源:陈涛

本人认为需要有新的键盘布局来适应眼动键盘输入,QWERTY 全键盘布局的权威地位是由于人们近百年来养成了不可撼动的使用习惯,促就如今地位。但是事实上如今 QWERTY 全键盘布局设计的初衷并不是为了帮助人们提高输入高效,而是机械式打字机为了降低在快速输入过程中容易出现的机械故障,因而设计成如今我们通用的反人类键盘布局。

但是完全用眼睛去输入文本是全新交互习惯,面对普通消费者则要追求交互的效率,所以有机会开辟出一种全新的基于眼动交互的输入法,并且眼动交互还存在大量的技术问题有待解决,所以是存在新的机会的。

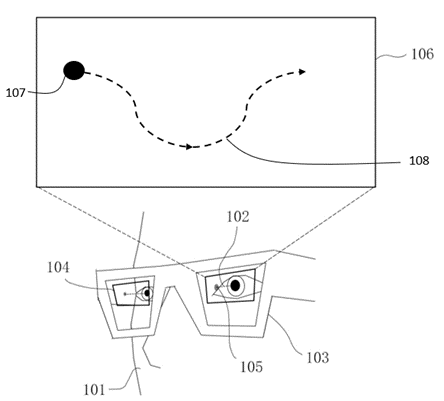

五.眼动人机识别

Vision Pro 眼镜对比于电脑、手机的 2D 屏幕内容呈现形式和交互方式发生了巨大的变化,例如 Vision Pro 眼镜呈现的内容是全息 3D 立体的,交互采用“眼动+手势”,那么现如今基于内容呈现形式和交互方式这两项构建的互联网基础都发生改变后,用传统的方法放在 AR/VR 眼镜上是不适用的,就比如“人机识别”,现如今的很多互联网产品通过短信验证码、正确输入难以理解的字母数字、拖拼图等等,用这种方式来识别用户是爬虫机器人还是真人用户,以此作为安全机制防止被薅羊毛。但在 AR/VR 场景下可以有哪些人机识别机制呢?

图源:苹果

例如,要求用户按照提示在空间中寻找正确的 3D 图标,并通过眼动注视点看着 3D 图标保持一定的时长。这是通过利用人对三维空间的意识理解和眼动交互实现的人机识别。

图源:陈涛

再进一步,作为拖动滑块拼图的眼动升级版,如上图中,系统随机生成一个光球在空间中不规则的移动,然后用户需要始终注视移动中的光球,直到光球到达终点。

这是通过人眼的追视行为和人眼无法凭空实现平滑移动的特性,以及光球在空间中深度(距离)发生变化时,人眼的视线夹角会产生变化等人类特有行为作为依据判断是真人还是爬虫机器人。除了上述提出的一些眼动人机识别方法,还有很多的眼动行为特性没有被挖掘,甚至大伙有可能会想到更好的技术方案。

六.眼动追踪与健康医疗、精神

来源:苹果

现在的智能手表基本功能重点在运动健康方面,比如心率、血氧、睡眠、压力、体温监测等技术,都已经比较成熟了,诸如苹果、华为、小米等智能手表。

但是在未来基于 AR 眼镜与眼动追踪技术同样具备健康检测与精神检测。目前在医学界眼动追踪技术是脑震荡、自闭症、小儿注意力缺陷等精神类病症的重要依据,那么是否在未来 AR 眼镜普及之后会诞生更多帮助改善注意力缺陷和自闭症的医学类 APP,这对于家长,以及一些特殊家庭的帮助是极大的。

基于 AR 眼镜的眼动追踪技术还可以做到脑异常、心脏异常、眼癌、高血压等心脑血管类身体疾病检查,因为可以通过眼动追踪技术获取眼睛的眼底图像,眼底的特征包括眼睛的视网膜,视盘,黄斑,中央凹,眼底的一些病变和眼睛的健康情况,通过 AI 对所获取的眼底图像进行图像分析是可以检测出一些疾病的。那么这对未来的智慧医疗的想象空间就很大了。

再者,业内人士也知道 Magic Leap 在消费者市场遇到挫折后,更换的新 CEO Peggy Johnson 将战略重心转向商业场景,尤其是医疗领域。

笔者看了 Magic Leap 将眼动追踪技术应用在医疗领域的相关专利文献,在他们的专利号 10365488 描述中,AR 眼镜加上眼动追踪技术有可以成为 “视力自动验光仪”、“眼底镜”、“裂隙灯”的眼科医学的检测设备,通过研究AR眼镜的眼动和光学成像技术发现其硬件结构就像微缩版视力自动验光仪。

图源:Magic leap 专利 US10359631

试想一下未来如果真的 AR 眼镜可以起到验光仪的作用,那么对于现在的眼镜店的变革也会很大,因为我们眼睛近视了,要去实体店通过验光仪测算眼睛的度数,然后再制作出相应度数的眼镜。但是如果眼睛近视度数在家就可以测算,将眼睛度数数据发送至后台工厂,然后再将加工好的眼镜寄送到客户家里,这也可能隔了传统眼镜店的命,传统实体眼镜的未来也是未知之数。

评论 (0)